Zukunft der Arbeit im Zeitalter von KI

Die Gesellschaft verändert sich, das betrifft auch die Arbeitswelt. Bei den Diskussionen über diese Prozesse fallen häufig Schlagworte wie digitaler Wandel, vierte industrielle Revolution, künstliche Intelligenz. Was genau steckt hinter diesen Begriffen, wo kommt es zu Überlagerungseffekten und wie wirken sich die Entwicklungen auf unser Verhalten im Arbeitsleben aus?

Bereits seit mehreren Jahren sind wir als Gesellschaft mittendrin im sogenannten "digitalen Wandel" und jeder und jede Einzelne ist in zunehmendem Maße sowohl im Privat- als auch im Berufsleben auf die Kommunikation mit digitaler Technologie angewiesen. Es wird (insbesondere für den Bereich der Produktionsarbeit) auch von einer vierten industriellen Revolution (Industrie 4.0) gesprochen. Die globale COVID-19-Pandemie hat den Prozess der Digitalisierung nochmals beschleunigt. Die notwendige gesellschaftliche Diskussion über dieses Phänomen und der Einfluss auf das Arbeitsleben haben nun eine weitere Welle erfahren, die unter dem Thema "künstliche Intelligenz (KI)" steht. Da sich hier verschiedene Effekte überlagern und insbesondere in der medialen Debatte die Begrifflichkeiten sogar teilweise synonym verwendet werden, soll dieser Artikel einen Überblick geben und eine Einordnung ermöglichen. Neben dem "Hype" und aller Diskussion über technologische Unterschiede sollte allerdings im Vordergrund stehen, was wir auch aus dem privaten Umgang mit neuen Technologien wissen: Eine wirkliche "Revolution" findet nicht dadurch statt, dass es neue Werkzeuge gibt, sondern dadurch, dass wir – oder die Gesellschaft insgesamt – auf Basis dieser neuen Werkzeuge neue Verhaltensmuster entwickeln.[1] Zur Gestaltung dieser Verhaltensmuster sind insbesondere alle gesellschaftlichen Akteurinnen und Akteure aufgerufen.

Kontext digitaler Wandel und industrielle Revolution

Im Rahmen des Fachdialogs "Mensch-Technik-Interaktion – Arbeiten mit KI" des Observatoriums Künstliche Intelligenz in Arbeit und Gesellschaft (KI-Observatorium) des Bundesministeriums für Arbeit und Soziales (BMAS)[2] wurde viele Male eine Überlappung verschiedener Begriffe und Vorstellungen identifiziert. Um die besonderen Auswirkungen von künstlicher Intelligenz zu verstehen, muss zunächst der Kontext der Veränderung der Arbeitswelt skizziert werden.

Während der Begriff Digitalisierung ursprünglich im technischen Sinne die Überführung von Informationen von einer analogen in eine digitale Speicherung bezeichnete, wird von "digitalem Wandel" oder eben auch "Digitalisierung" im sozioökonomischen Sinn gesprochen, wenn die gesellschaftliche Adaption neuer Technologien und damit einhergehende Veränderungen thematisiert werden.[3] Eine Vielzahl von Begriffen wird verwendet, um verschiedene Strömungen oder Aspekte der Digitalisierung zu beschreiben, wie zum Beispiel das "Web 2.0" (Schlagwort für eine Reihe interaktiver und kollaborativer Elemente des Internets), das "Internet of Things" (Sammelbegriff für Technologien, die es ermöglichen, physische und virtuelle Objekte miteinander zu vernetzen), "Big Data" (Datenmengen, die beispielsweise zu groß, zu komplex, zu schnelllebig oder zu schwach strukturiert sind, um sie mit manuellen und herkömmlichen Methoden der Datenverarbeitung auszuwerten) oder eben jetzt auch künstliche Intelligenz (zur Definition siehe nächster Abschnitt). Diese Begriffe haben mehrere Gemeinsamkeiten: Sie bezeichnen eine große Gruppe einzelner Technologien, sie sind hinreichend unscharf definiert und sie werden mittlerweile als Marketingbegriffe verwendet (was weiter zur Unschärfe beiträgt). Verstärkt durch apokalyptische Warnungen selbst ernannter Technikphilosophen[4] wird ein "Buzzword" kreiert, das suggeriert, dass jeder Mensch, beziehungsweise insbesondere jedes Unternehmen, Produkte dieses Labels unbedingt benötige und gleichzeitig, dass man diese – ähnlich wie beispielsweise eine Buchhaltungssoftware – einfach im Paket einkaufen könne. Obwohl es sich vielfach um tiefgreifende Umgestaltungsprozesse handelt, steht in der öffentlichen Diskussion fälschlicherweise die Technologie im Vordergrund und nicht der Prozess.

Eine wirkliche 'Revolution' findet nicht dadurch statt, dass es neue Werkzeuge gibt, sondern dadurch, dass wir – oder die Gesellschaft insgesamt – auf Basis dieser neuen Werkzeuge neue Verhaltensmuster entwickeln.

Ein weiterer prägender Begriff ist die "Industrie 4.0"[5] als Bezeichnung der Auswirkungen von Innovationen der Informationstechnik im Kontext der industriellen Produktion. Dieser Gedanke einer "vierten industriellen Revolution" wird mittlerweile auch international verwendet. Anstatt sich lediglich auf den Bereich der Produktion zu beziehen, wird beispielsweise auch der generelle Wandel der Arbeitswelt unter dem Einfluss der Digitalisierung zunehmend mit "Arbeit 4.0" bezeichnet.[6] Gesellschaftliche Umbrüche, die durch technologische Neuerungen ausgelöst wurden, gab es in der Geschichte zuhauf. Während die Durchnummerierung der "industriellen Revolutionen" bis zur aktuellen "vierten" industriellen Revolution den fälschlichen Eindruck eines diskreten Stufenmodells hervorruft, ist es vielmehr so, dass sie "bei Weitem keine linearen technischen bzw. technologischen Innovationspfade beschreiben, sondern komplexe, widersprüchliche und umkämpfte Entwicklungsschritte, in denen sich vielfältige wirtschaftliche und gesellschaftliche Herausforderungen stellen"[7]. Auch die weiteren Veränderungen in Gesellschaft und Arbeitsleben im Kontext von künstlicher Intelligenz sind nicht isoliert zu betrachten, sondern in diesen Prozess des digitalen Wandels oder der "industriellen Revolution" eingebettet.

Künstliche Intelligenz ist unscharf definiert

Wie bereits erwähnt, fällt der Fachwelt eine eindeutige Definition sehr schwer. Zum Beispiel stellen Legg und Hutter[8] unterschiedliche Definitionen von "Intelligenz" zusammen, um deutlich zu machen, dass eine klare Definition "künstlicher Intelligenz" nahezu unmöglich ist. Besonders deutlich wirken sich hier die unterschiedlichen Ausrichtungen und Arbeitsweisen einzelner Fachbereiche aus. Auch die KI-Strategie der Bundesregierung[9] verweist auf diesen Umstand und unterscheidet – sehr allgemein – zwischen "starker" und "schwacher" KI, die "menschenähnliche oder höhere Intelligenz" beziehungsweise alle anderen "niedrigeren" Anwendungsformen maschinellen Lernens bezeichnen. Die Bundesregierung sowie die Enquete-Kommission zur Künstlichen Intelligenz[10] stellen zugleich fest, dass die "starke" KI aktuell nicht erreicht werden kann (und möglicherweise nie erreicht werden wird), sodass sich Förder- und Regelungsmaßnahmen auf die Anwendungen "schwacher" KI beschränken. Beispielsweise wird der gesamte Bereich der Robotik als Teil von Implementierungen "schwacher" KI beschrieben.

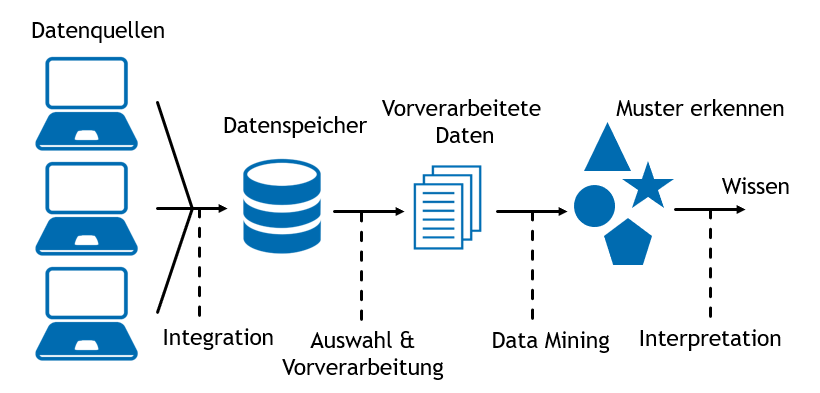

Als Synthese dieser Abgrenzungen wird meist mit "künstlicher Intelligenz" der Versuch bezeichnet, bestimmte menschliche Verhaltens- oder Entscheidungsstrukturen nachzubauen, sodass ein Computerprogramm eigenständig Probleme bearbeiten kann. In Abbildung 1 wird dazu eine Schemazeichnung dargestellt. Zunächst werden verschiedene Datenquellen in einen gemeinsamen Datenspeicher integriert. Nach einer Vorverarbeitung findet das eigentliche "Data Mining"[11] statt, in dem Muster in den Daten erkannt werden – beispielsweise die Zuordnung von Datensätzen oder Teilen von Datensätzen zu vorher feststehenden Übergruppen (Klassifizierung). Mit dieser recht einfachen Abbildung lässt sich die Mehrzahl von "KI"-Anwendungen beschreiben: Bei der Smartphone-Navigation beispielsweise sind die Datenquellen die verschiedenen anderen App-Nutzenden, durch deren Geschwindigkeit auf manchen Autobahnen man ableiten kann, dass es zu Verzögerungen oder Staus kommt. Aber auch Online-Shopping-Empfehlungen ("Kunden, die dieses Produkt kauften, interessierten sich auch für dieses Produkt") lassen sich in dieses Schema bringen. Zum Verständnis von KI-Anwendungen hilft es, dieses Schema als Blaupause zu verwenden, um sich über die verschiedenen Teile des Systems einen Überblick zu verschaffen.

Für einen intuitiveren Zugang zur Leistungsfähigkeit von Systemen künstlicher Intelligenz sind das Selbstausprobieren und dabei insbesondere das Erfahren der Grenzen der Leistungsfähigkeit der Algorithmen hilfreicher als abstrakte Definitionen. Daher ist es dringend zu empfehlen, das umfangreiche Informationsmaterial rund um dieses Thema selbst zu erkunden. Als Start der Entdeckungsreise bietet sich beispielsweise der vom Bundesministerium für Bildung und Forschung (BMBF) geförderte KI-Campus[12] an. Interaktive Beispiele gibt es ebenfalls eine große Menge, hier empfiehlt sich der Start bei Google[13] und insbesondere mit der Anwendung QuickDraw[14], die Handskizzen erkennt. Gerade bei "Chatbots", also Programmen, die eine automatisierte schriftliche Kommunikation ermöglichen, realisieren Nutzende sehr schnell, dass sie nicht mit einem "echten Menschen" reden. Diese Erfahrung entspricht dem bereits 1950 beschriebenen "Turing-Test": Hier wird in einem Experiment eine Chatkommunikation hergestellt. Wenn ein echter Mensch nicht mehr unterscheiden kann, ob er mit einer Maschine oder mit einem Menschen Nachrichten hin- und herschickt, wird postuliert, dass der Computer ein dem Menschen gleichwertiges Denkvermögen hat. Der seit 1951 ausgeschriebene Loebner-Preis soll an das Computerprogramm verliehen werden, das als erstes einen erweiterten Turing-Test besteht – allerdings konnte bisher kein Computerprogramm die nötigen Voraussetzungen erfüllen.

Wer ist besser – Mensch oder KI?

Die Überlegung des Turing-Tests führen uns zu einer grundlegenden Frage: Wo ist die künstliche Intelligenz "besser" als der Mensch? Ein Grund, warum KI-Anwendungen aktuell so intensiv diskutiert werden, ist die Befürchtung, dass durch weitergehende Automatisierung menschliche Arbeit ersetzt werden könnte. Zur grundlegenden Einordnung "Wer ist besser?"gibt es wiederum bereits eine lange andauernde wissenschaftliche Diskussion. Insbesondere im Bereich der Flugassistenzsysteme stellte sich nämlich eine ähnliche Frage wie die, die wir aktuell im Kontext des Einsatzes von künstlicher Intelligenz für Produktionssteuerung oder weiteren anderen Anwendungen am Arbeitsplatz diskutieren. 1950 wurde von Fitts die Partitionierung "Humans are better at/Machines are better at" (HABA MABA)[15] vorgestellt, in der grundlegend überlegt wurde, dass Maschinen beispielsweise schneller auf Kontrollsignale reagieren können als Menschen und insbesondere bei sich wiederholenden Aufgaben effektiv eingesetzt werden können. Menschen seien dagegen besser im Improvisieren, bei flexiblen Anwendungen und könnten (im Gegensatz zu Maschinen, die deduktiv schließen) induktiv Schlüsse ziehen. Diese Sichtweise wurde lange kritisch diskutiert, ergänzt und beispielsweise 2003 durch das Modell der Autonomiestufen[16] ersetzt, in dem es nicht darum geht, wer (Mensch oder Maschine) was macht, sondern wer was wann macht: Anstatt eine starre Aufgabenteilung zwischen Automatisierung und Mensch zu finden, kann das Maß der Kontrolle des Menschen während eines Prozesses immer mal wieder zu- und abnehmen.

Auch die weiteren Veränderungen in Gesellschaft und Arbeitsleben im Kontext von künstlicher Intelligenz sind nicht isoliert zu betrachten, sondern in diesen Prozess des digitalen Wandels oder der 'industriellen Revolution' eingebettet.

Auch heute diskutieren wir beispielsweise im Kontext von Industrie 4.0 Autonomiestufen[17] für künstliche Intelligenz. Die Frage "Wer ist besser?" lässt sich nämlich nur in Trivialfällen einfach beantworten. Natürlich ist ein Roboter schneller und stärker als ein Mensch, und ein Computerprogramm hat bereits 1997 den amtierenden Schachweltmeister geschlagen. Aber bei Gesichtserkennung ist die Maschine vielleicht besser als ein Mensch,[18] aber noch nicht gut genug, um bei Gefährder-Erkennung nicht zu viele Falschmeldungen zu produzieren[19]. Beim Autofahren würde ein autonomes Auto zwar weniger Verkehrsunfälle produzieren, aber die Gesellschaft akzeptiert menschliches Versagen eher als maschinelles Versagen[20]. Insbesondere für komplexere Antworten oder Prozesse läuft es an vielen Orten nicht auf eine Abwägung von "Mensch oder Computer", sondern auf eine intelligente Kombination von menschlicher Arbeitskraft mit Computerunterstützung hinaus (ähnlich sieht mittlerweile auch die Praxis im Bereich der Flugassistenzsysteme aus).

Auswirkungen von KI auf die Arbeit der Menschen

Es gibt zahlreiche Einsatzszenarien für Algorithmen und künstliche Intelligenz im beruflichen Alltag. Im Versuch eines kleinen Überblicks über das Themenfeld seien hier einige Themen angerissen.

Kleine Helfer

Computerprogramme sind Bestandteil der meisten Arbeitsplätze und einige dieser Programme arbeiten aktuell bereits mit Methoden des maschinellen Lernens. Insbesondere im Bereich der Texterkennung und Bildverarbeitung gibt es schon seit Langem Hilfsmittel, die mittlerweile auch täglich eingesetzt werden, wie beispielsweise OCR (Optical Character Recognition) zur Überführung von gescannten Dokumenten in bearbeitbaren Text oder Diktiersysteme, die menschliche Sprache in Text überführen. Auch Chatbots für die Abwicklung von Servicedienstleistungen und Verträgen werden immer stärker als Hilfsmittel eingesetzt. Diese "kleinen Helfer" sind die Mehrzahl der KI-Programme und ersetzen zwar auch menschliche Arbeitskraft, werden aber in der gesellschaftlichen Diskussion kaum als Bedrohung wahrgenommen.

Beschäftigungseffekte

Die Sichtweise "Roboter nehmen uns die Arbeit weg" als Dystopie wurde nicht zuletzt aufgrund von Hollywood-Literatur fest in Köpfen von Beschäftigten verankert und sorgt für Zukunftsangst. Auf einer Internetseite mit dem provokanten Titel "Will robots take my job?"[21] kann man nachschlagen, ob der eigene Job demnächst von der künstlichen Intelligenz übernommen wird. Diese Seite basiert auf den sehr einflussreichen Betrachtungen von Frey und Osborne[22], die auch in den deutschen Medien Widerhall gefunden haben. Diese Sichtweise hat zahlreiche Kritiker und Kritikerinnen – so bezieht sich das Modell auf den amerikanischen Markt und dabei bei näherer Betrachtung lediglich auf die „Wahrscheinlichkeit der Veränderung“ durch Digitalisierung, die aber nicht notwendigerweise mit einer Ersetzung von menschlicher Arbeit durch Roboter beziehungsweise künstliche Intelligenz einhergeht. Die Internetseite zusammen mit der Studie zeigen erneut, dass die Debatte nicht zwischen den Auswirkungen des digitalen Wandels und jenen der künstlichen Intelligenz trennen kann. Eine sehr gute Relativierung und einen Überblick über diese verschiedenen Zukunftsszenarien präsentieren Ittermann und Niehaus[23]: Neben der bereits vorgestellten dystopischen Zukunftsvision zeigen sie die Literatur zu weiteren möglichen Zukunftsszenarien auf, die aktuell diskutiert werden. So gilt es vor allem das positive Szenario zu erwähnen, das beispielsweise in der Betrachtung der Boston Consulting Group[24] aufgespannt wird. Hier wird betont, dass sich Arbeit durchaus wandeln wird, aber dass dies eben nicht zwangsweise zu einem Beschäftigungsrückgang führt. Eine weitere Studie vom Zentrum für Europäische Wirtschaftsforschung (ZEW) nimmt sogar einen Zuwachs von 560.000 Stellen an.[25]

Für einen intuitiveren Zugang zur Leistungsfähigkeit von Systemen künstlicher Intelligenz sind das Selbstausprobieren und dabei insbesondere das Erfahren der Grenzen der Leistungsfähigkeit der Algorithmen hilfreicher als abstrakte Definitionen.

Datenschutz bezüglich der Plattformen

Sobald Technik Daten über Arbeitsprozesse und Menschen sammelt, muss der Technikanbieter vertrauenswürdig sein, da zumindest theoretisch bei unverschlüsseltem Datentransfer alle übertragenen Daten von der Plattform eingesehen werden können. Aber selbst wenn der eigentliche Inhalt verschlüsselt wird, lassen sich durch die sogenannten Metadaten (also zum Beispiel wer hat wie lange mit wem geschrieben) wertvolle Informationen gewinnen. Im privaten Bereich ist diese Diskussion durch die kritische Diskussion um Messengerdienste wie Whatsapp bereits gesamtgesellschaftlich angekommen. Natürlich gelten für berufliche Kommunikation genau dieselben Bedenken und es muss auch berücksichtigt werden, dass vermeintlich "private" Messengerdienste zunehmend im beruflichen Kontext eingesetzt werden.

Arbeitnehmerdatenschutz

Die prinzipielle Möglichkeit des Zugriffs gilt natürlich nicht nur für die Plattform, sondern auch für den Arbeitgeber und die Arbeitgeberin. Arbeitnehmerinnen und Arbeitnehmer müssen daher in Zeiten des covidinduzierten Digitalisierungsschubs besonders vor möglichen ungewollten Zugriffen oder Überwachungsmöglichkeiten ihrer Arbeitstätigkeiten beschützt werden. Dies muss auch im Kontext der weiteren technologischen Entwicklung gesehen werden – wenn beispielsweise ein Algorithmus die Tätigkeiten der Arbeitnehmerinnen und Arbeitnehmer aufzeichnet, so kann gegebenenfalls mithilfe von maschinellem Lernen eine weitere Automatisierung (zum Beispiel bei Sachbearbeitungsvorgängen) angestrebt werden. Nicht nur der Arbeitgeber oder die Arbeitgeberin schaut einem dann über die Schulter, sondern auch der Algorithmus.

Bedienbarkeit

Die im Rahmen des Digitaltages durchgeführte Studie von Bitkom Research[26] stellt fest, dass auch über die Altersgruppen hinweg Digitalisierung ein fester Teil des Alltags der 1.005 Befragten ist. Dabei sind die Älteren (65 Jahre und älter) skeptischer als Jüngere. Weiterhin stellt die Studie fest, dass der Umgang mit technischen Geräten nicht allen leichtfällt und die fehlende Nutzerorientierung als das größte Hemmnis wahrgenommen wird. Das muss einerseits von Herstellerseite angegangen werden und bei Forschungs- und Entwicklungsprojekten einen (noch) größeren Stellenwert erhalten. Gleichzeitig muss aber auch der gesamtgesellschaftliche Anspruch der Herstellung einer "Digital Literacy" (digitalen Mündigkeit, in Deutschland hauptsächlich unter dem verkürzten Begriff Medienkompetenz gefasst) der Gesamtbevölkerung diskutiert werden. Speziell in Bezug auf künstliche Intelligenz wird zunehmend auch eine "AI Literacy" gefordert, also das Entwickeln der grundsätzlichen Fähigkeit, die Leistungsfähigkeit von KI-Systemen einzuschätzen und zu bewerten. Ein spezieller Aspekt der Bedienbarkeit sei nochmals besonders hervorgehoben, nämlich die Kontrollierbarkeit des technischen Systems durch die Nutzenden und das Gefühl, das System auch kontrollieren zu können (Human Supervisory Control). Gerade wenn Entscheidungsprozesse oder Teile davon durch die künstliche Intelligenz erfolgen, muss der Mensch in der Lage sein, diese Entscheidungsprozesse nachzuvollziehen (Explainable AI).

Arbeit muss als soziotechnisches System verstanden werden und technologische Neuerungen müssen in diesem Kontext untersucht und für diesen Kontext entwickelt werden.

Bias im Datensatz

70 bis 80 Prozent der deutschen Unternehmen nutzen laut einer Befragung des Institute for Competitive Recruiting sogenannte Bewerbermanagementsysteme, bei denen ein Algorithmus Bewerbungen gegen die Jobkriterien abgleicht. Das zugespitzte Problem: Wenn der Algorithmus sich nach existierendem Führungspersonal in deutschen Unternehmen richten würde, würde er für eine neu zu besetzende Führungsposition lediglich die Bewerbung von Männern über 45 Jahre ohne Migrationshintergrund akzeptieren und alle anderen ablehnen. Die Diskussion, wie man allerdings Algorithmen zur Identifikation von derartigen Bias benutzen kann, wird aktuell fortgeführt[27] – schließlich ist das Problem nicht der Algorithmus, sondern der Datensatz, auf dessen Basis die Entscheidung gelernt wird.

Fazit

Das "alte" Thema der sozialwissenschaftlichen Arbeitsforschung – nämlich die Frage nach dem Verhältnis von Technik und Arbeit – hat bereits im Kontext Industrie 4.0 eine Renaissance erfahren und diese Debatte wird, wie oben dargestellt, durch den Aspekt der künstlichen Intelligenz noch verstärkt. Die Effekte des digitalen Wandels allgemein vermischen sich dabei mit denen der künstlichen Intelligenz, nur wenige Aspekte werden in der medialen Diskussion trennscharf betrachtet. Wie wir aktuell in täglichem Arbeitskontext feststellen, ist der Zusammenhang zwischen der Verbreitung digitaler Technologien und ihrer sozialen Konsequenzen "keinesfalls linear und eindeutig festgelegt zu verstehen"[28]. Arbeit muss als soziotechnisches System verstanden werden und technologische Neuerungen müssen in diesem Kontext untersucht und für diesen Kontext entwickelt werden.

Die Diskussion muss interdisziplinär und mit den verschiedenen Statusgruppen geführt werden. So gibt es bereits vonseiten der Arbeitnehmer und Arbeitnehmerinnen[29] als auch vonseiten der Arbeitgeber und Arbeitgeberinnen[30] erste Handlungsempfehlungen für die Einführung von KI-Systemen. Ein interdisziplinärer Ansatz wird aktuell vom KI-Observatorium verfolgt.[31] Ein Ergebnis sind praxisnahe Handreichungen[32] die die Bedeutung von Co-Designs[33] und partizipativen Gestaltungsprozessen[34] in "handfesten" Ratschlägen formulieren.