Einsatz von KI im Maschinenschutz: Funktionale Sicherheit im Fokus

In besonders kritischen Anwendungen wie dem Maschinenschutz ist die Zuverlässigkeit aller Systemkomponenten besonders wichtig, um die Sicherheit der Bedienenden zu gewährleisten. Systeme mit künstlicher Intelligenz, die dort eingesetzt werden sollen, müssen daher Kriterien der funktionalen Sicherheit erfüllen. Schwierigkeiten und Einsatzmöglichkeiten stellt dieser Artikel dar.

Derzeit erregt künstliche Intelligenz in nahezu allen Bereichen großes Aufsehen. Auch im Arbeitsschutz eröffnet KI eine Reihe von Möglichkeiten, etwa bei der Vorhersage von Unfallrisiken oder durch individualisierte Schulungen. Aber auch in Bereichen der klassischen funktionalen Sicherheit, wie etwa dem Maschinenschutz, gibt es verschiedenste Möglichkeiten, wie KI eingesetzt werden kann, um die Sicherheit für die Bedienenden einer Maschine zu erhöhen und Unfälle zu vermeiden. Gleichzeitig ist gerade in diesem Bereich die Zuverlässigkeit der Systeme von größter Wichtigkeit. Dieser Artikel beleuchtet die verschiedenen Einsatzmöglichkeiten von KI im Maschinenschutz, die damit verbundenen Besonderheiten hinsichtlich funktionaler Sicherheit und Prüfung solcher Systeme sowie die rechtlichen Grundlagen.

Einsatzmöglichkeiten von KI im Maschinenschutz

KI-Systeme bieten vielfältige Anwendungsmöglichkeiten im Bereich des Maschinenschutzes. Ein besonders relevantes Beispiel ist die Objekterkennung etwa aus Bilddaten mit dem Ziel, Gefahr bringende Situationen zu vermeiden. KI kann zur Erkennung von Personen oder Objekten an Gefahrstellen und Gefahrbereichen eingesetzt werden, um Unfälle zu vermeiden. Beispielsweise können Kameras und Sensoren, die mit KI-Algorithmen ausgestattet sind, Situationen in Echtzeit analysieren und Maschinenbewegungen automatisch stoppen, wenn eine möglicherweise gefährliche Situation erkannt wird. Bei schwierigen Einsatzbedingungen wie Anwendungen im Outdoorbereich kann KI helfen, Systeme sicher, aber auch möglichst störungsfrei zu betreiben.

Ein weiteres Anwendungsfeld ist die präventive Wartung. Durch die Analyse von Sensordaten können KI-Systeme den Zustand von Maschinen überwachen und vorhersagen, wann Wartungsarbeiten erforderlich sind. Dies reduziert nicht nur Ausfallzeiten, sondern kann auch Unfälle verhindern, indem potenzielle Gefahren frühzeitig erkannt und behoben werden. In der Industrie können solche Systeme dazu beitragen, die Sicherheit der Arbeitsumgebung zu erhöhen, indem sie Anomalien im Betrieb erkennen und frühzeitig Wartungsmaßnahmen einleiten.

Ein indirekter Einsatz von KI im Maschinenbereich ist die Verwendung von KI-basierten Tools bei der Entwicklung von Maschinen oder auch klassischen Sicherheitsfunktionen. Das können zum Beispiel allgemeine oder spezialisierte Chatbots sein, die Teile eines Programmcodes schreiben. Hier ist zwar das Ergebnis eine klassische Software, allerdings setzen viele Methoden zur Prüfung von Software auch auf eine Analyse des Entwicklungsprozesses, um systematische Fehler zu vermeiden. Gleichfalls fordern generische Normen der funktionalen Sicherheit qualifizierte Werkzeuge. Diese Anforderungen bei der Verwendung von KI-Tools zu erfüllen, ist nicht ohne Weiteres möglich.

Funktionale Sicherheit und Prüfung von KI-Systemen

Die funktionale Sicherheit von KI-Systemen im Maschinenschutz ist ein zentrales Thema, das besondere Aufmerksamkeit erfordert. Funktionale Sicherheit bezieht sich auf die Fähigkeit eines Systems, sicher zu funktionieren, und zwar auch dann, wenn Ausfälle auftreten. Ein rigoroser Sicherheitsnachweis für KI-Systeme ist mit klassischen Methoden nicht möglich, weil diese Systeme zwar im Kern deterministisch sind, ihr Verhalten aber nach außen hin oft als nicht deterministisch wahrgenommen wird, da kleinste Änderungen in den Randbedingungen teilweise großen Einfluss auf die Entscheidung eines KI-Systems haben können. Klassische sicherheitskritische Systeme folgen festen Regeln und ihre Reaktionen auf bestimmte Eingaben sind vorhersehbar. KI-Systeme hingegen lernen aus Daten und ihre Entscheidungen basieren auf Wahrscheinlichkeiten. Dies macht KI-Systeme flexibler, aber auch weniger transparent und schwerer zu validieren, da es zu einer inhärenten Unsicherheit führt.

Ein großes Problem bei KI-Systemen, insbesondere bei tiefen neuronalen Netzen, ist die mangelnde Nachvollziehbarkeit. Es ist oft unklar, wie diese Systeme zu ihren Entscheidungen kommen. Ein weiterer kritischer Punkt ist die Testabdeckung. Es ist unmöglich, alle in Betracht kommenden Szenarien und Bedingungen, unter denen ein KI-System arbeiten muss, vollständig zu testen. Dies führt zu Unsicherheiten in der Zuverlässigkeit der Systeme. Robuste Testmethoden und Metriken zur Bewertung der Testabdeckung sind daher unerlässlich. Die Einhaltung von Normen wie ISO 13849[1] und IEC 61508[2] ist für die funktionale Sicherheit von entscheidender Bedeutung. Diese Normen legen Sicherheitsanforderungen für Sensoren und Steuerungen fest. Diese Anforderungen gelten auch für die Bewertung von KI-basierten Sicherheitssystemen. Allerdings können die darin beschriebenen Methoden nur begrenzt auf KI-Systeme übertragen werden.

Die Entwicklung spezifischer Normen für KI-Systeme ist im Gange und wird in Zukunft eine wichtige Rolle spielen. Solche Normen müssen die besonderen Eigenschaften von KI-Systemen berücksichtigen, um eine angemessene Bewertung ihrer Sicherheit zu ermöglichen. Ein erstes, bereits veröffentlichtes Dokument aus diesem Bereich ist der Technische Report ISO/IEC TR 5469:2024 Functional Safety and AI Systems.[3]

Zusammenfassend lässt sich sagen, dass Prüfung und Zertifizierung von KI-Systemen im Maschinenschutz komplex und herausfordernd sind. Sie erfordern neue Ansätze und Methoden, um die Sicherheit dieser Systeme zu gewährleisten. Die fortschreitende Forschung und Entwicklung sowie die technische Ausformulierung der Anforderungen aus rechtlichen Rahmenbedingungen durch neue Normen werden dabei eine entscheidende Rolle spielen.

KI-basierte Assistenzsysteme

Aktuell bieten insbesondere sogenannte Assistenzsysteme die Möglichkeit, von den Chancen, die KI für den Arbeitsschutz bietet, zu profitieren, ohne einen rigorosen Sicherheitsnachweis führen zu müssen. Deutsche Prüfstellen, darunter das Institut für Arbeitsschutz der DGUV (IFA), haben mit dem GS-BAU-70 „Grundsätze für die Prüfung und Zertifizierung von sicherheitsrelevanten Assistenzsystemen an Maschinen und Nutzfahrzeugen“[4] einen Prüfgrundsatz erarbeitet, der die Anforderungen an solche Systeme festlegt. Ein Assistenzsystem wird darin definiert als „ein Unterstützungssystem für die Benutzenden stationärer und mobiler Maschinen, das zu Bedienungsaufgaben eine assistierende Funktion leistet bzw. in Bedienungsaufgaben Fehlern und Fehlverhalten entgegenwirken soll“.

Wichtig ist, dass Assistenzfunktionen nach dieser Definition formal keinen Beitrag zu einer erforderlichen Risikominderung liefern und daher nur zusätzlich zu bereits bestehenden Sicherheitsfunktionen oder -einrichtungen eingesetzt werden können. Dies ist besonders für KI-Systeme interessant, da so trotz der beschriebenen Schwierigkeiten bei der Absicherung und Prüfung von KI bereits Nutzen daraus gezogen werden kann. Assistenzsysteme müssen jedoch trotzdem nach bestimmten Anforderungen und Qualitätsstandards entwickelt werden. Diese Anforderungen umfassen die Zuverlässigkeit des Systems, die Transparenz der Funktion und Zuverlässigkeit für die Bedienenden sowie die Berücksichtigung der vorhersehbaren Anwendung an der Maschine.

Der Prüfgrundsatz GS-BAU-70 richtet sich nicht speziell an KI-basierte Komponenten oder Systeme und enthält daher keine spezifischen technischen Anforderungen. Der Einsatz von Assistenzsystemen darf keine neuen Gefährdungen erzeugen oder zusätzliche Risiken mit sich bringen, das gilt besonders für KI-Anteile. Es gilt, die allgemeinen Anforderungen des Prüfgrundsatzes, insbesondere in Bezug auf Zuverlässigkeit und Transparenz, einzuhalten. Die Berücksichtigung KI-spezifischer Fehlermodelle ist wichtig, da sie die Zuverlässigkeit und Robustheit des Systems beeinflussen und somit dessen Sicherheit direkt betreffen. Darüber hinaus können die Erwartungen der Nutzenden durch die öffentliche Wahrnehmung von KI-Leistungen beeinflusst werden, daher ist es wichtig, ein transparentes System zu schaffen, das die Grenzen der KI klar kommuniziert.

Rechtliche Grundlagen

Die Europäische Union hat mit der KI-Verordnung (EU) 2024/1689 (KI-VO)[5] einen einheitlichen Rechtsrahmen geschaffen, der die Entwicklung, das Inverkehrbringen und die Verwendung von KI-Systemen regelt. Diese Verordnung legt Anforderungen etwa an die Robustheit, die Transparenz und Qualität der Daten fest, um Risiken für Gesundheit, Sicherheit oder Grundrechte zu minimieren.

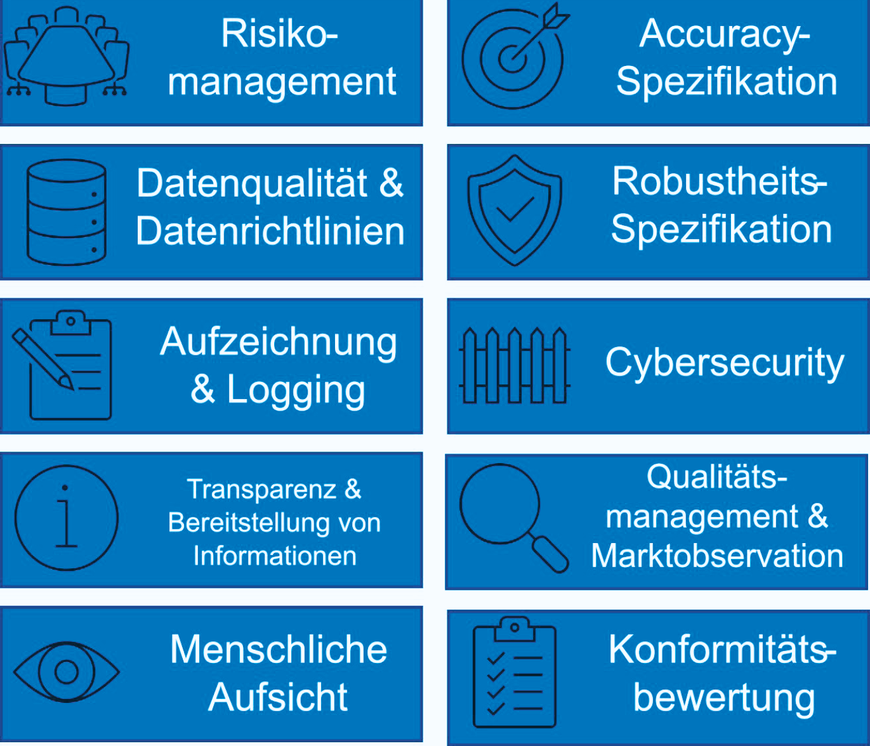

Die Verordnung unterscheidet zwischen verschiedenen Risikostufen für KI-Systeme. Systeme mit einem unannehmbaren Risiko, wie etwa solche, die zur Manipulation oder zur Bewertung des sozialen Verhaltens eingesetzt werden, sind verboten. Hochrisiko-KI-Systeme, die potenziell nachteilig auf die Sicherheit der Menschen oder ihre Grundrechte wirken können, unterliegen strengen Anforderungen. Die Anforderungskategorien der KI-VO an Hochrisikosysteme sind in Abbildung 1 dargestellt.

Insbesondere Robustheit ist eine spezielle Herausforderung für KI-Systeme, da sie in komplexen Umgebungen eingesetzt werden, die Unsicherheiten beinhalten. Die Robustheit eines KI-Systems bezieht sich auf seine Fähigkeit, auch mit Anwendungsfällen umzugehen, die nicht exakt den Trainingsdaten entsprechen. Dies umfasst beispielsweise die Robustheit gegenüber Bildfehlern, Schwankungen in Helligkeit und Kontrast oder Umweltbedingungen wie Verschmutzungen.

Speziell für den Einsatz von KI in Maschinen spielt außerdem die Maschinenverordnung (EU) 2023/1230 (MV)[6] zukünftig eine entscheidende Rolle. Diese Verordnung ersetzt die bisherige Maschinenrichtlinie 2006/42/EG und passt die Vorschriften an die aktuellen und zukünftigen Anforderungen in Bezug auf die Sicherheit von Maschinen an. Sie enthält erstmals Aussagen über die Verwendung von KI in Sicherheitsbauteilen. So werden in Anhang II der Verordnung („Nicht erschöpfende Liste der Sicherheitsbauteile“) unter Nr. 19 „Sicherheitsbauteile mit vollständig oder teilweise selbstentwickelndem Verhalten unter Verwendung von Ansätzen des maschinellen Lernens“ aufgeführt. KI-spezifische Anforderungen werden in der MV nicht genannt. Es gibt jedoch eine enge Bindung an die KI-VO, die ein System automatisch als Hochrisikosystem einstuft, wenn

a) das KI-System als Sicherheitsbauteil eines Produkts verwendet wird, das unter die Maschinenrichtlinie (MRL)[7] oder die MV fällt, und

b) dieses Produkt nach MRL oder MV einer Konformitätsbewertung durch Dritte bedarf.

Für diesen Fall müssen im Rahmen einer Konformitätsbewertung nach MRL/MV auch die Anforderungen der KI-VO beachtet werden.

Fazit

Der Einsatz von KI im Maschinenschutz kann verschiedene Vorteile bieten, erfordert jedoch sorgfältige Überlegungen und Maßnahmen zur Risikominimierung. Die funktionale Sicherheit von KI-Systemen ist dabei ein zentrales Thema, das besondere Aufmerksamkeit verlangt. Aktuell ist es aufgrund von technischen und regulatorischen Herausforderungen bei der Entwicklung und Prüfung von KI-Systemen noch schwierig, diese als Sicherheitsfunktionen zu verwenden. Mit fortschreitender Forschung und Entwicklung sowie klaren gesetzlichen und normativen Vorgaben wird es zukünftig wahrscheinlicher, dass ein solcher Nachweis möglich ist. Bis dahin ist der Einsatz von KI-Systemen als Assistenzfunktionen eine gute Möglichkeit, die Potenziale der KI im Maschinenschutz auszuschöpfen und gleichzeitig zu mehr Sicherheit beizutragen.